Künstliche Intelligenz (KI) / Artificial Intelligence (AI): Künstliche Intelligenz bezieht sich auf die Simulation von menschenähnlicher Intelligenz in Maschinen oder Computern. Es ermöglicht Maschinen, Probleme zu lösen und Aufgaben auszuführen, die normalerweise menschliche Intelligenz erfordern.

Maschinelles Lernen (ML) / Machine Learning (ML): Maschinelles Lernen ist ein Teilbereich der KI, der es Computern ermöglicht, aus Daten zu lernen und Muster zu erkennen, ohne explizit programmiert zu werden. Es verwendet statistische Techniken, um Modelle zu erstellen und Vorhersagen zu treffen. Mehr dazu im Artikel:

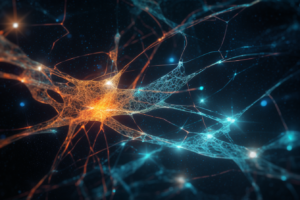

Tiefes Lernen / Deep Learning: Tiefes Lernen ist eine spezielle Art des maschinellen Lernens, die auf künstlichen neuronalen Netzwerken basiert und mehrere versteckte Schichten hat. Es kann komplexe Muster in großen Datenmengen erkennen und ermöglicht erstaunliche Fortschritte in Spracherkennung, Bildverarbeitung und Spieltheorie.

Mehr dazu im Artikel: Deep Learning: Eine Einführung für Anfänger + DeepDive in Neuronale Netze

Neuronale Netzwerke / Neural Networks: Neuronale Netzwerke sind Rechenmodelle, die lose auf der Struktur und Funktion des menschlichen Gehirns basieren. Sie bestehen aus Knoten oder Neuronen, die miteinander verbunden sind, und sind in der Lage, komplexe Muster und Zusammenhänge in Daten zu lernen und zu erkennen.

Überwachtes Lernen / Supervised Learning: Überwachtes Lernen ist eine Methode des maschinellen Lernens, bei der Modelle mit Hilfe von beschrifteten Trainingsdaten trainiert werden. Dabei wird das Modell aufgrund der Eingabe-Ausgabe-Paare in den Trainingsdaten angepasst, um die Leistung bei der Vorhersage neuer, unbekannter Daten zu optimieren.

Unüberwachtes Lernen / Unsupervised Learning: Unüberwachtes Lernen ist eine Methode des maschinellen Lernens, bei der Modelle ohne beschriftete Trainingsdaten trainiert werden. Stattdessen lernt das Modell, Muster und Strukturen in den Daten selbstständig zu erkennen, um Aufgaben wie Clustering oder Dimensionsreduktion durchzuführen.

Bestärkendes Lernen / Reinforcement Learning: Bestärkendes Lernen ist eine Art des maschinellen Lernens, bei der ein Agent in einer Umgebung agiert und durch Belohnungen oder Bestrafungen lernt, optimale Entscheidungen zu treffen. Das Ziel ist es, eine Strategie oder Politik zu entwickeln, die die kumulative Belohnung im Laufe der Zeit maximiert.

Transferlernen / Transfer Learning: Transferlernen ist eine Technik im maschinellen Lernen, bei der ein bereits trainiertes Modell auf eine neue, aber ähnliche Aufgabe angewendet wird. Dabei wird das vorhandene Wissen des Modells genutzt, um den Trainingsaufwand für die neue Aufgabe zu reduzieren und die Leistung zu verbessern.

Natural Language Processing (NLP): Natural Language Processing ist ein Teilbereich der KI, der sich mit der Interaktion zwischen Computern und menschlicher Sprache befasst. Es umfasst Techniken und Algorithmen, die es Computern ermöglichen, menschliche Sprache zu verstehen, interpretieren und generieren. Anwendungen von NLP umfassen maschinelle Übersetzung, Spracherkennung und Chatbots.

Convolutional Neural Networks (CNN): Convolutional Neural Networks sind eine spezielle Art von neuronalen Netzwerken, die besonders gut für Bildverarbeitung und Computer Vision geeignet sind. Sie nutzen Faltungsoperationen, um lokale Merkmale in Bildern zu erkennen und zu lernen, was zu einer besseren Leistung bei Aufgaben wie Bildklassifikation führt.

Recurrent Neural Networks (RNN): Recurrent Neural Networks sind eine Art von neuronalen Netzwerken, die speziell für die Verarbeitung von sequenziellen Daten entwickelt wurden. Sie haben Schleifen, die es ihnen ermöglichen, Informationen aus früheren Schritten im Netzwerk zu speichern und zu nutzen, was sie besonders nützlich für Text- und Zeitreihenanalyse macht.

Long Short-Term Memory (LSTM): Long Short-Term Memory ist eine spezielle Art von RNN, die entwickelt wurde, um das Problem der verschwindenden Gradienten zu lösen, das bei Standard-RNNs auftritt. LSTMs können langfristige Abhängigkeiten in Daten besser lernen und eignen sich gut für Aufgaben wie Textgenerierung und maschinelle Übersetzung.

Generative Adversarial Networks (GAN): Generative Adversarial Networks sind eine Art von neuronalen Netzwerken, die aus zwei konkurrierenden Netzwerken bestehen – einem Generator und einem Diskriminator. Der Generator erzeugt künstliche Daten, während der Diskriminator versucht, echte von gefälschten Daten zu unterscheiden. GANs werden häufig zur Erstellung realistischer Bilder, Videos und Tonaufnahmen eingesetzt.

Decision Trees: Decision Trees sind ein maschinelles Lernverfahren, das auf der Konstruktion von Baumstrukturen basiert, um Entscheidungen zu treffen. Sie sind einfach zu interpretieren und können sowohl für Klassifikations- als auch für Regressionsaufgaben eingesetzt werden.

Random Forests: Random Forests sind ein Ensemble-Lernverfahren, das mehrere Decision Trees kombiniert, um robuster gegenüber Overfitting zu sein und bessere Vorhersagen zu treffen. Sie werden für eine Vielzahl von Aufgaben eingesetzt, darunter Klassifikation, Regression und Feature Selection.

Gradient Boosting Machines (GBM): Gradient Boosting Machines sind eine weitere Ensemble-Methode, die Decision Trees verwendet. Im Gegensatz zu Random Forests werden die Bäume jedoch sequenziell trainiert und auf den Fehlern der vorherigen Bäume aufgebaut, um die Leistung zu verbessern.

Support Vector Machines (SVM): Support Vector Machines sind ein maschinelles Lernverfahren, das darauf abzielt, den optimalen Trennungsrand zwischen Klassen in einem Datensatz zu finden. SVMs sind besonders effektiv für lineare und nichtlineare Klassifikationsprobleme mit kleineren Datensätzen.

K-means Clustering: K-means Clustering ist ein unüberwachtes Lernverfahren, das darauf abzielt, Datenpunkte in Gruppen oder Cluster zu teilen, basierend auf ihrer Ähnlichkeit. Es ist ein iterativer Algorithmus, der die Clusterzentren (Mittelwerte) anpasst, um die Summe der quadrierten Abstände innerhalb der Cluster zu minimieren.

Principal Component Analysis (PCA): Principal Component Analysis ist eine statistische Methode zur Dimensionsreduktion, die darauf abzielt, die wichtigsten Merkmale in einem Datensatz zu identifizieren und redundante Informationen zu entfernen. Es transformiert die Daten in einen neuen Raum, in dem die Hauptkomponenten unkorreliert sind und die Varianz maximiert wird.

Bayessche Netzwerke / Bayesian Networks: Bayessche Netzwerke sind eine Art von probabilistischen Graphenmodellen, die auf der Bayes’schen Statistik basieren. Sie repräsentieren die bedingten Abhängigkeiten zwischen Variablen und ermöglichen die Schätzung von Wahrscheinlichkeiten und die Vorhersage von Ereignissen unter Unsicherheit.

Lineare Regression / Linear Regression: Lineare Regression ist eine statistische Methode zur Modellierung der Beziehung zwischen einer abhängigen Variable und einer oder mehreren unabhängigen Variablen. Sie verwendet die Methode der kleinsten Quadrate, um die beste angenäherte Linie zu finden, die die Abstände zwischen den tatsächlichen und vorhergesagten Werten minimiert.

Logistische Regression / Logistic Regression: Logistische Regression ist eine Art der linearen Regression, die speziell für binäre Klassifikationsprobleme entwickelt wurde. Sie verwendet die logistische Funktion, um die Wahrscheinlichkeit eines Ereignisses vorherzusagen und kann auf Probleme wie Spam-Erkennung und medizinische Diagnose angewendet werden.

Regularisierung / Regularization: Regularisierung ist eine Technik im maschinellen Lernen, die dazu verwendet wird, Overfitting zu verhindern, indem sie eine Strafe für komplexe Modelle einführt. Es gibt verschiedene Methoden der Regularisierung wie L1- und L2-Regularisierung, die zur Anpassung der Modellparameter und zur Erhaltung der Generalisierungsleistung beitragen.

Overfitting: Overfitting tritt auf, wenn ein maschinelles Lernmodell die Trainingsdaten zu gut lernt und dabei seine Fähigkeit, neue, unbekannte Daten zu verarbeiten, beeinträchtigt. Es ist ein häufiges Problem, das durch Techniken wie Regularisierung, Cross-Validation und Ensemble-Methoden angegangen werden kann.

Underfitting: Underfitting ist das gegenteilige Problem von Overfitting und tritt auf, wenn ein Modell nicht in der Lage ist, die zugrunde liegende Struktur der Daten zu erfassen. Dies kann aufgrund einer zu einfachen Modellarchitektur, unzureichendem Training oder fehlender Merkmale auftreten.

Cross-Validation: Cross-Validation ist eine Technik zur Bewertung der Leistung von maschinellen Lernmodellen, bei der die Trainingsdaten in mehrere Teilmengen aufgeteilt werden. Das Modell wird auf einer Teilmenge trainiert und auf der verbleibenden Teilmenge getestet, um eine unvoreingenommene Schätzung der Generalisierungsleistung zu erhalten. K-Fold Cross-Validation ist eine häufig verwendete Variante dieser Technik.

Hyperparameteroptimierung / Hyperparameter Optimization: Hyperparameteroptimierung bezieht sich auf den Prozess, die besten Hyperparameter für ein maschinelles Lernmodell zu finden, um die Modellleistung zu verbessern. Es gibt verschiedene Suchstrategien wie Grid Search, Random Search und Bayesian Optimization, die zur Optimierung von Hyperparametern verwendet werden können.

Feature Engineering: Feature Engineering ist der Prozess der Erstellung, Auswahl und Transformation von Merkmalen, um die Leistung von maschinellen Lernmodellen zu verbessern. Es kann die Entfernung von irrelevanten oder redundanten Merkmalen, die Kombination von vorhandenen Merkmalen oder die Erstellung neuer Merkmale aus Rohdaten beinhalten.

Feature Selection: Feature Selection ist ein Teil des Feature Engineering und bezieht sich auf den Prozess der Auswahl der relevantesten und informativsten Merkmale für ein maschinelles Lernmodell. Dies kann die Modellkomplexität reduzieren, Overfitting verhindern und die Trainingszeit verkürzen.

Bagging: Bagging (Bootstrap Aggregating) ist eine Ensemble-Methode, die darauf abzielt, die Stabilität und Genauigkeit von maschinellen Lernmodellen zu verbessern. Es funktioniert, indem mehrere Modelle auf unterschiedlichen Teilmengen der Trainingsdaten trainiert und ihre Vorhersagen aggregiert werden.

Künstliche Neuronen / Artificial Neurons: Künstliche Neuronen sind die grundlegenden Bausteine von neuronalen Netzwerken und sind von biologischen Neuronen inspiriert. Sie empfangen Eingangssignale, gewichten und kombinieren sie und verwenden eine Aktivierungsfunktion, um ein Ausgangssignal zu erzeugen.

Perzeptron / Perceptron: Das Perzeptron ist ein einfacher Typ eines künstlichen Neurons und ein früher Algorithmus für maschinelles Lernen. Es besteht aus einer linearen Gewichtung der Eingaben, gefolgt von einer Schwellenwert-Aktivierungsfunktion, und kann für binäre Klassifikation verwendet werden.

Backpropagation / Backpropagation: Backpropagation ist ein Lernalgorithmus für neuronale Netzwerke, der auf der Kettenregel der Differentiation basiert. Es wird verwendet, um den Fehler im Netzwerk rückwärts von der Ausgabeschicht zur Eingabeschicht zu verbreiten und die Gewichte anzupassen, um den Fehler zu minimieren.

Aktivierungsfunktionen / Activation Functions: Aktivierungsfunktionen sind Funktionen, die in künstlichen Neuronen verwendet werden, um die gewichteten Eingangssignale zu transformieren und ein Ausgangssignal zu erzeugen. Häufig verwendete Aktivierungsfunktionen sind die Sigmoid-, ReLU- und Tanh-Funktionen. Sie fügen Nichtlinearität in neuronale Netzwerke ein und ermöglichen das Lernen komplexer Muster.

Loss-Funktionen / Loss Functions: Loss-Funktionen, auch als Kostenfunktionen bezeichnet, sind Funktionen, die den Unterschied zwischen den tatsächlichen und vorhergesagten Werten in einem maschinellen Lernmodell quantifizieren. Sie werden verwendet, um das Modell während des Trainings anzupassen und zu optimieren. Häufig verwendete Loss-Funktionen sind der quadratische Fehler, die Kreuzentropie und der Hinge Loss.

Optimierer / Optimizers: Optimierer sind Algorithmen, die verwendet werden, um die Modellparameter im maschinellen Lernen, insbesondere in neuronalen Netzwerken, anzupassen und zu optimieren. Sie minimieren die Loss-Funktion, indem sie die Gewichte und Bias-Werte basierend auf Gradienteninformationen anpassen. Beispiele für Optimierer sind der Gradientenabstieg, der stochastische Gradientenabstieg und der Adam-Optimierer.

Dropout: Dropout ist eine Regularisierungstechnik für neuronale Netzwerke, die Overfitting reduziert, indem sie während des Trainings zufällig ausgewählte Neuronen „ausschaltet“. Dies führt zu einer besseren Generalisierung, da das Netzwerk weniger abhängig von einzelnen Neuronen wird und mehr robuste Merkmale lernt.

Batch-Normalisierung / Batch Normalization: Batch-Normalisierung ist eine Technik, die in neuronalen Netzwerken angewendet wird, um das Training zu beschleunigen und die Generalisierungsleistung zu verbessern. Sie normalisiert die Aktivierungen der Neuronen in einer Schicht, indem sie deren Mittelwert und Varianz innerhalb einer Minibatch anpasst, wodurch das Netzwerk stabiler und schneller konvergiert.

Datenvisualisierung / Data Visualization: Datenvisualisierung bezieht sich auf die grafische Darstellung von Daten und Informationen, um komplexe Zusammenhänge und Muster besser verständlich zu machen. Es gibt viele Techniken und Tools zur Datenvisualisierung, wie Histogramme, Streudiagramme, Balkendiagramme und Heatmaps, die in der Datenanalyse und im maschinellen Lernen verwendet werden.

Datenmanipulation / Data Manipulation: Datenmanipulation bezieht sich auf den Prozess der Veränderung, Anpassung und Umwandlung von Daten, um sie für die Analyse und das maschinelle Lernen vorzubereiten. Dazu gehören Techniken wie das Filtern, Sortieren, Zusammenführen und Aggregieren von Daten, um sie in eine geeignete Form für die Verwendung in Modellen zu bringen.

Datenbereinigung / Data Cleaning: Datenbereinigung ist ein wichtiger Schritt in der Datenvorbereitung, der darauf abzielt, Fehler, Inkonsistenzen und Unvollständigkeiten in den Daten zu identifizieren und zu beheben. Dies kann das Entfernen oder Korrigieren von fehlenden, inkonsistenten oder falschen Werten, das Entfernen von Duplikaten und das Normalisieren von Daten in einem konsistenten Format beinhalten.